ビッグデータとは

近年、ビッグデータという言葉を良く聞くようになりました。それまでは、巨大データや情報爆発などのように、データの巨大化が注目されてきたわけですが、そこにIBMさんがビッグデータという言葉を作り、世に送り出しました。IBMさんの言うビッグデータは「volume(量)」「velocity(速度)」「variety(多様性)」の3つの特徴を持つデータのことを言うそうです。つまり大量で、かついろいろなものが混ざっている、ということですね。ただし、ここで言う「速度」は「データを使うときに速い計算が必要」という意味で、つまり大量にデータがやってくるので、それを整理してデータベースに蓄えたり、いろんな人に提供するときに速度が必要、という意味です。これは、データ自体の説明ではなく、「ビッグデータはこういう目的に使うものなのですよ」ということなので、データの説明ではないように思います。もともとIBMさんが商売のために考えた言葉ですので、コンピュータが売れるような文句になっているのでしょう :-)

ビッグデータという言葉、時代にフィットしていたようで、あっという間に世に広まりました。データを使って何かしないと、いい仕事ができない、と感じている研究者やビジネスパーソンが多かった、あちこちにある巨大なデータの持つ可能性が大きく感じられた、ということがあるのでしょう。IBMさんの思惑以上だと思うのですが、ビッグデータは世に言うバズワードになり、研究する人ビジネスする人、ビッグデータに興味、あるいは業務的必要性を感じるようになりました。そうなると、いろいろな疑問が出てきます。「ビッグデータって何ができるの?」「うちのデータはビッグデータなんですか?」データを持つ人、データに関わる人が、自然とこういう疑問を持つようになってきます。

特に、ビッグデータとは何か、という質問は、非常に多くの人が抱えているようです。「どれくらい大きくなったらビッグデータなんですか?」「スパコンを使わないとビッグデータじゃないんですか?」「ヒトゲノムや国勢調査のデータは、非常に大きいですが、あれはビッグデータなんですか?」などなど。でも、答えはありません。IBMさんが定義したビッグデータ以上に、ビッグデータという言葉はいろいろなところに使われ、一人立ちした概念になってしまったのです。つまり、「誰も答えを知らない」のです。これでは、ビッグデータをはじめようとする人は、すぐに迷子になってしまいます。

そうは言っても、世の中の人々がなんとなくビッグデータはこうだな、と思っていることはあるようです。「以前はなかった、大きなデータで、解析が大変なもの」という感じです。ここが、ビッグデータの本質なのでしょう。ただし、この3つを全て満たす必要はないようで、この中のいくつかを満たし、ビッグデータ的な使われ方をしているものがビッグデータ、と感じるようです。使われ方については「ビッグデータの使い方」で解説しますので、ここでは、このように定義されるビッグデータってなんなんでしょうか、というところに焦点を当てましょう。

最近世に出てきた大きなデータと言えば、Webのデータ、ゲノムのデータ、センサーデータ、などです。Webサイトのアクセスの履歴(ログ)、スマホや車のナビからとれる、人や車の位置と移動のデータ、温度計や降雨レーダーなどの気象のデータ、工作機械などに取り付けられた、診断用の振動や音のデータ、健康診断や医療、心拍計や体温などの生体データなどがこれに当たります。以前からこのようなデータ、存在はしていたのですが、最近センサーが高性能になった上に価格が下がり、インターネットも進化したことで、データの取得とデータセンターへの送付が格段に楽になり、大規模に出来るようになったので、様々な巨大なデータが出現することとなったのです。ビッグデータの特徴の一つは、「センサーなどで半自動的に集められたもの」と言っていいでしょう。

二番目の「大きさ」ですが、実は人々は、データの大きさに興味はないようです。なぜかというと、人々の興味は、実は「解析が大変かどうか」にあって、「大きいデータは解析が大変だ」と考えているから大きさが出てくるのです。データベースとコンピュータを売りたい会社には、「大きいことはいいことだ」なんでしょうけど :-)。解析の難しさは、解析の目的とデータの質によります。例えば、国勢調査の巨大なデータがあって、これは大変だと思っても、やりたいことが日本の人口を知ることであれば、単にデータの項目を数えるだけです。コンピュータなら一瞬でしょう。同じように、男女比を調べるのも一瞬です。そもそも、統計的なことを言わせていただければ、男女比を調べるだけであれば、5000件くらいのデータをランダムに抜き出して(サンプリング)調べれば、ほぼ正確な数字がわかりますので、データを全部見る必要もありません。データ全体の特徴を表す数字、平均とか分散とか中央値や比率などは、意外と簡単に計算できるのです。

計算するのが難しいのはもっと細かいものです。細かいと言っても、各項目、つまり個人個人のデータを観るという話ではありません。例えば、この住所にある会社は何だろう、のようなことを調べるのは、単なるデータの検索であり、解析ではありません。国勢調査のデータであれば「最近住んでる人の層が変わったのはどの地域?」「長生きな人のライフスタイルはどうなってる?」「子育てが活発なのは、どういう暮らしぶりの人たち?」と言った、より複雑で、単なる数値では表しにくいことを知るために行うのが、データの解析です。

こういったことを調べるとき、要因が1つ、あるいは数個であれば、解析は簡単です。例えば、いろいろなデータを取って、身長が伸びる理由は何かな、と、身長の高さとライフスタイルの様々な事柄を比べたとします。ここで、身長が伸びるかどうかが、牛乳をたくさん飲んだかどうかだけで決まる世界だったとしましょう。すると、身長と牛乳を飲んだ量にはきれいな関係(相関関係と言います)が出てくるはずで、身長の高い人ほど牛乳を沢山飲んでいるのが見て取れるはずです。逆に、他の項目では、このような相関は全く観られないはずです。身長と関係ないわけですから。この要因が複数、例えば牛乳を飲み、かつ運動を良くする人だけが身長伸びるとか、あるいは牛乳を飲むか魚を沢山食べるか、などのように少数個であれば、やはり解析は簡単です。問題は、要因がたくさんありそうなとき、あるいははっきりした関係があるものが少なそうなときです。現実世界では、身長が伸びる要因は、親の身長や、兄弟の身長、栄養状態、運動の量、住んでいる地域、普段の姿勢、様々な要因が絡んでいると思われますし、どれか一つ、あるいは複数を満たしたからと言って、必ず身長が伸びるわけでもありません。ここが、解析の難しさ、です。

いろんなタイプの人がいて、原因となるものがたくさんありそうで、それぞれが複雑に絡み合っている。こういうデータを「多様性が高い」と言います。多様性の高さ、知りたいものの複雑さが、解析の難しさの原因です。データが、知りたいことの要因となる、意味のあるデータになっていないとき、データは「初等的である」と言います。例えば、スマホの位置情報はとても正確ですが、場所を正確に教えてもらっても、なんでそこに来たのか、仕事なのか遊びなのか、楽しいのかつらいのか、などの情報はわかりません。人間の行動を調べるのに、位置データは初等的すぎるのです。データが初等的であることも、データ解析の難しさです。

データが目的なく集められているのも、最近のデータの特徴です。昔は、データは「わざわざ」集めていた、つまりなんか知りたいことがあるので、アンケートをとったり、町に出て調査したりしたわけです。つまり知りたいことがわかるように、集めるデータは決められてました。でも、最近は逆で、まずデータがあることが多いです。この「まずデータありき」も最近のビッグデータ時代の流れの1つです。例えばtwitterのつぶやきを分析し、インフルエンザの流行を検知したいとします。単にインフルエンザに関するつぶやきの個数を調べ、多くなればインフルエンザが流行しているのだろう、と考えます。実際、インフルエンザにかかってない、あるいはインフルエンザの人が周りにいない人は、インフルエンザの話題をあまり出さないので、確かにこれで流行をとらえられそうです。でも、インフルエンザにかかった人は必ずtwitterに投稿するわけではないですし、「インフルなう」「熱出てやばい感じ」のようにつぶやく人もいるかもしれません。インフルエンザの流行を調べるためにデータをとるのであれば、みなさん、インフルエンザにかかっているかどうかしっかり答えてくれるでしょう。でも、twitterのつぶやきは、みなさん別の目的や楽しみでやっていること、もともとインフルエンザとは関係ないのです。でも、インフルエンザのつぶやきだって、確かにあるでしょう。流行しているときには増えるでしょう。そこには、何らかの関連(相関)があってしかるべきです。目的が異なるデータを扱うのは大変なのですが、データは高い、アンケートをたくさんとれば莫大なお金がかかるので、今あるデータを使って精度が多少悪くなってもなんとかしよう、と考えるのは、とても合理的なのです。このように、もともと目的なく、あるいは違う目的で集められたデータを、他の目的に使う、このような使い方をするのは、ある種現代風、ビッグデータ流です。

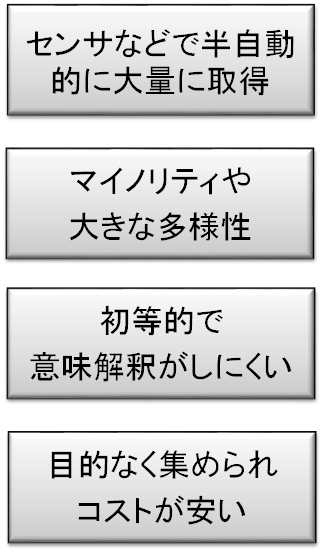

図のように、以上をまとめると、ビッグデータの特徴は、

図のように、以上をまとめると、ビッグデータの特徴は、

- センサーなどで半自動的に集められたデータ

- 多様性が高く、マイノリティも含まれる

- 初等的で意味解釈が難しい

- 目的なく集められているが、コストが安い

となります。これらの特徴をある程度備えていれば、たとえ大きさがそれほどでなくても、ビッグデータとよんでいいでしょう。これが、私の考える、私が見立てた、「ビッグデータとは何か」です。

ビッグデータには、まだ正確な定義はありません。ビッグデータの学会があるわけでもないですし、政府が何かを決めているわけでもありません。どこかの企業の所有物でもありませんから、どこぞの会社が決めるというものでもありません。こういうものは、時間が経つにつれて、だんだんに決まっていくものと思います。世の人々が、ああ、ビッグデータってこんな感じのものなんだな、と思い始め、それが共有されるようになり、多くの人がうっすらと同じように考えるようになったところで、定義が決まるのでしょう。言葉とはそのようなものだと思います。じゃあそれまでは何も言わないのかというと、そうではありません。今は、いろんな人が「ビッグデータとはこういうものだ」と、自分の意見を言う時代なのだと思います。そうしていろんな意見が混ざり合って、世の人々の共通認識が決まっていくのでしょう。なので、私は、今は自分が見えている、考えているものの中から最もいい意見を出していきます。