ビッグデータの使い方

近年、センサ技術やIT技術の発達により、大量のデータが簡単に集められるようになりました。望まずとも自動的にデータを記録しているデバイスや機械も多く、場合によっては期せずして大量のデータを手に入れている人や会社も多いと思います。おりしもビッグデータを使った新しいビジネスや研究が注目される中、自分の手持ちのデータをなんとかしたいという人もいらっしゃいます。その場合、データを使って何をしたいのか、目的がなく、手段としてのビッグデータだけが存在するという、面白い状況になります。

その一方で、データの所有者はそのデータに興味がないが、第三者から見ると宝の山に見えるような場合もあります。長い時間継続的にためられたデータは、すぐに同じようなものを作るのは不可能ですし、特殊な病気の人のデータは、治療法や新薬の開発に役に立つかもしれません。その人にとっては役に立たなくても、価値観や目的を異にする人には宝物であることも少なくないのです。

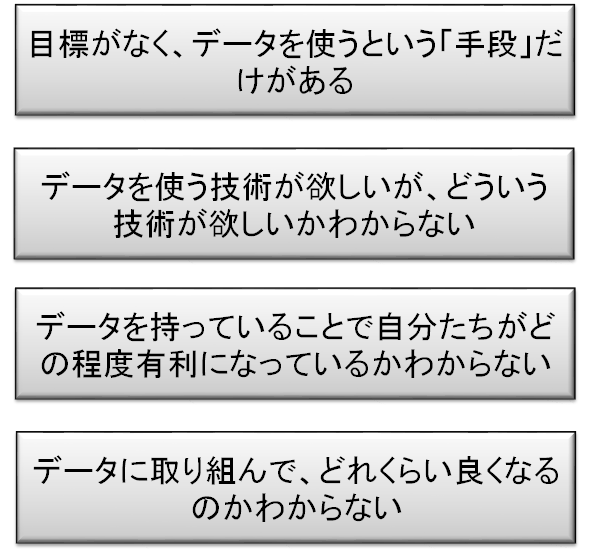

企業や研究室などで、データは持っているが、うまく使えないなくて困っている、というときには、以下のようなパターンがあるようです。

企業や研究室などで、データは持っているが、うまく使えないなくて困っている、というときには、以下のようなパターンがあるようです。

- 目標がなく、データを使うという「手段」だけがある

- データを使う技術が欲しいが、どういう技術が欲しいかわからない

- 自分たちが、データを持つことによってどの程度有利になっているかわからない

- データに取り組んで、どれくらい良くなるのかわからない

こういった、そもそもの部分がはっきりとせず、悩み、迷いのようなものがあるので、なかなか着実に歩を進めるのが難しいのでしょう。この解説のような文章が役に立てばいいのですが、個別のデータに対しては、やはりそのデータを判じる人、病気を判じるお医者さんや、ビジネスを判じるコンサルタント、あるいは古物を判じるアンティークショップのような人も必要でしょう。

ビッグデータは目的なく集められ、あるいは集めた目的と違う目的で解析されることが少なくありません。これは、データの持つ多面的な価値を余すところなく引きだそうというもので、データサイエンス的なアプローチ、あるいはビッグデータ流のデータ解析としてはある種の王道だと考えます。

しかし、ただ闇雲に使えばいいというのではなく、いい結果、精度の高い結果を得るためには、やはりビッグデータの質に合わせた、ゴール設定と解析手法が重要になります。技術の基本、こういうデータからこんなことがわかるものだ、という定石がわかっていれば、手に入ったデータをどう料理すべきかわかるでしょう。学術産業の両面で、人によって場所によって何ができるとうれしいか、大きく変わります。様々な分野での多様な価値のゴールを知っていれば、データから導き出せるであろう事柄に合わせて、どこをゴールにすれば良いか上手に設計できると思います。こうしたことには、なんと言っても経験が大きくものを言います。たくさん勉強して、自分の発想を豊かにして、というアプローチでも良いですが、知識のある人、発想が豊かな人に相談して、助けてもらうというのも、良いと思います。聞くべき相手を探し出すこと自体がビッグデータを検索しているようなものですね。

ビッグデータの性質は、初等的、多様性、および大量。そう考えると、個別の項目に精度高く答えるのは苦手です。多くの質問に、60%なり70%なりの精度で答える、というのが得意になります。60%の精度で何ができるのだろうと思うかもしれませんが、例えば株価が上がるか下がるかの予想であれば、60%の確率で儲かることになります。60%の確率で儲かる取引を何回も何回も行えば、ほぼ確実に儲けを得ることができるでしょう。ある商品の評判を分析したいと思うときも、一人の意見は60%くらいでしか正しく理解できなくても、大量の人のデータがあればその精度の悪さを補えます。ビッグデータは、その大きさが難しいように思えますが、こうしてみると逆に、大きいことがメリットになるのです。

1万人に一人の珍しい病気の調査がしたいとしましょう。1万人分のデータを集めても、サンプルはせいぜい1,2人。これでは何が原因か、どういう治療がいいのか、推測するすべもありません。しかし、もし1000万人のデータが集まれば、1000人分の症例が集まります。これなら、病気の原因や特徴も推測できそうです。いろんなライフスタイルの人たちの、いろいろ病気の症例が混在するデータ、つまり多様性の高いデータに対しても、データが多量であれば、1つ1つの症例、ライフスタイルに対して、十分な数のサンプルが得られることになり、解析が非常に楽になります。

Webや雑誌を見ると、ビッグデータの利用による新しいビジネスについて記されたものを多く見ます。しかし、今まで述べてきたような視点から見ると、その多くはビッグデータっぽく見えません。最後に、それらビッグデータでなさそうなものを並べて見たいと思います。そして最後に、ビッグデータっぽいものについても解説を行いたいと思います。

- ● 食品や製品のトレーサビリティ(どこの牧場からいつ来て、どこで加工されたか、といった情報)を確保する

→ データをためて、検索できるようにするだけなので、ビッグデータ流ではない。RFIDなどセンサやチップを使って楽に出来るようにするところに本質がある。

- ● スキャニングによる不良品判定

→ センサー、特に画像認識アルゴリズムの問題

- ● スケジュール管理、配送計画

→ データと言うよりは、最適化。どのような条件の下、どのようなロジックで決めていくかが重要。未割当ての日数の最小化とか、運送コストの最小化など評価がしっかりしている面がある一方で、現場での暗黙の了解を考慮しないプランが出てくると使いにくくなり、そのあたりの調整をどう進めるかが鍵になる。データは、過去にあるものを使うというより、今日の予定を入力するもの。

- ● コールセンターのログ解析

→ コールセンターの会話の様子は、典型的なビッグデータではあるが、手間取った応対の分析やクレーマーの分析など、大きなデータの解析よりは個々の会話記録の解析が多いようだ。

- ● 詳細な製品の個性の分析に基づく対応型の加工・製造

→ 過去のデータからノウハウを集めている。ノウハウは人間が経験や調査から得る、抽象的な概念であり、言語化してコンピュータで処理することは難しい。そういう意味では、データ収集して、人間が解析するものなのであろう

- ● 建機に取り付けたセンサーから稼働状況や燃料残量などを把握

→ センサーのデータをデータセンターに送信し、残量などをチュックするものなので、ビッグデータ流ではない。データをどうやって低コストで送信できるかが本質

- ● 勤怠情報を電子化

→たんにITシステムの導入。問題は、得られたデータをどうするか

- ● 遠隔地からのプラント管理、プラント故障アラート

→センサとリモートコントロールシステムの問題。センサのデータを解析して、複雑な事象に対して自動管理をしたり、異常事態の予測をするならビッグデータ流

続いて、ビッグデータっぽく考えられるものです。

- ● 田んぼがたくさん写った航空写真を解析し、それぞれ畑の出来具合を畑の色や画像的な特徴から推定

→ 今までにない視点から、今入手可能なデータを安く使い、自動的にそこそこの精度の解を得ようとしている

- ● 気象データをなるべくリアルタイムで解析して、発電設備のある場所周辺の風速や日照を予測し、風力発電や太陽光発電の効率を推定(安定した電力供給のため)

→ 発電効率の予測を失敗すると、電気を余計に作ったり足りなくなったりしてしまう。いつも余分に発電すればエネルギーの損失になる。発電所の周辺の天気を細かく調べ、風向きも調べれば、雲の位置や風力の変化が正確に予測できる。今までの天気予報は、全国くまなく予報が必要だが、重要なところをピンポイントで行う気象予測には、それほどコストはかからない。

- ● twitter分析による株価予測

→ 株価は、経済が良くなれば上昇し、経済が悪くなれば下落する。経済を予測するのは難しいが、人々の景況感をたくさん調べれば、それなりの見通しは立つ。そこで、twitterに投稿された文章がポジティブかネガティブかを判定し、それらの数によって景況感を推測して、それで株価の動きを予測する。

- ● HDDの稼働時間やエラー回数などを収集し、HDDの故障時期を予測

→ 「これが大きくなったら故障する」という形の明確な法則性はないが、様々なデータから多角的に判断しようというのは、ビッグデータ的

- ● 東京ゲートブリッジに大量のセンサをつけて、異常を検知する

→ センサをたくさんつけて情報を集めるのは、IoTというべきだが、そういう初等的なデータから橋の状態を推定しようすることは、とてもビッグデータ的

- ● 製品を様々なセンサで調べ、不良品を自動検出

→ 不調品の特徴は様々だが、それをいろいろなセンサの値や、撮影した画像の特徴などから見つけようとするところがビッグデータ的